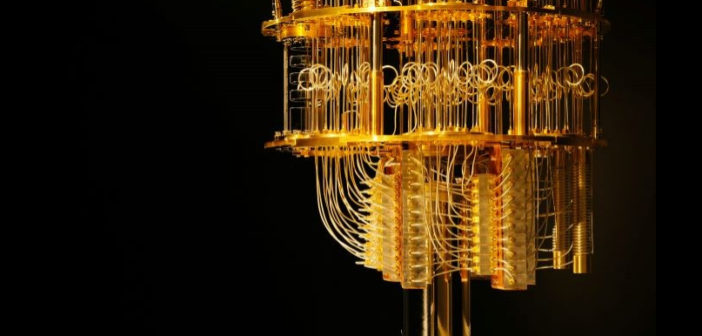

Les banques et sociétés d’investissements testent l’informatique quantique pour évaluer les apports de la technologie dans la gestion des risques et l’évaluation des portefeuilles. Zoom sur l’évolution de ces premiers projets et sur l’utilisation d’une technologie qui pourrait changer la donne pour ce secteur. (Photo IBM)

S’il est un secteur où l’informatique est omniprésente, c’est bien celui de la finance. Les problèmes d’optimisation, pour lesquels toute une série de variables doit être ajustée avec précision, se posent régulièrement à ces entreprises, en particulier lorsqu’il s’agit de produits financiers très élaborés, tels que ceux développés via l’analyse quantitative.

Ce besoin de modélisation mathématique complexe et à grande échelle fait de l’industrie financière un candidat parfait pour se frotter à l’informatique quantique. Celle-ci permet d’effectuer des calculs extrêmement rapidement, y compris les plus complexes, et de fournir des résultats en quelques minutes ou heures, là où un ordinateur classique, même très puissant, aurait besoin de semaines ou de mois.

Au-delà de la vitesse, c’est bien la capacité de l’informatique quantique à fournir des connaissances précises dans des délais raisonnables pour une activité économique qui la rend particulièrement précieuse, explique Benno Broer, directeur commercial de la start-up française Pasqal, spécialisée sur le sujet. « Prenons l’exemple de la fixation du prix de quelque chose, qu’il faudrait faire avec le plus de précision possible, dans un délai d’une heure. Avec un ordinateur classique, cela prendrait deux semaines et l’opportunité serait perdue », illustre le responsable.

Maximiser les rendements, minimiser les risques

Mieux calculer est l’une des raisons qui ont poussé une équipe mixte d’ingénieurs et d’analystes financiers de la société de services financiers new-yorkaise Ally Financial à se tourner vers le quantique. Ils se sont concentrés sur les fonds négociés en bourse (ETF), qui comprennent des centaines de milliers d’actions produisant un certain rendement sur une période donnée. Le principe est le suivant : même si quelques éléments individuels sont moins performants, les autres soutiennent le résultat net, ce qui permet d’obtenir un rendement relativement prévisible sur une période déterminée. Mais gérer et manipuler autant d’éléments constitutifs reste ardu : « nous faisons face à énormément de variabilité en termes de performance des actions, à beaucoup d’achats et de ventes et de frais de transaction connexes », explique Sathish Muthukrishnan, CIO, directeur data et du digital chez Ally.

Le CIO et l’équipe d’Ally ont cherché à savoir s’ils pouvaient obtenir des rendements similaires avec un ETF comportant moins de composantes. Pour ce faire, ils ont exploré le problème d’optimisation des « contraintes de cardinalité » et développé une approche hybride, mélangeant informatiques quantique et classique, maximisant les rendements et minimisant les risques. Leur travail leur a valu le prix 2023 US CIO 100 Award pour l’innovation IT et le leadership.

L’équipe d’Ally a utilisé une méthode appelée recuit quantique qui l’a aidée à choisir quelques actions. « Grâce à cette approche, vous êtes en mesure de sélectionner un plus petit nombre d’actions avec un rendement prédictif et des coûts opérationnels et de transaction plus faibles, ce qui signifie en fin de compte que vous pouvez réduire la variabilité et prédire les rendements avec plus de précision », explique Sathish Muthukrishnan. Grâce aux capacités quantiques, l’équipe d’Ally a pu créer 50 scénarios distincts et tester les modèles. Une telle rigueur met également en évidence les failles des modèles utilisés pour l’informatique traditionnelle et aide les entreprises à déployer des fondations plus solides pour leurs recherches sur la donnée, observe le DSI.

S’attaquer à des calculs complexes

Le travail d’Ally sur les ETF n’est qu’un exemple de ce qui pourrait s’avérer un changement radical pour le secteur financier, grâce à la puissance de calcul quantique. Cirdan Capital, une société d’investissement européenne, est un autre exemple d’organisation financière mettant l’informatique quantique à contribution. Cirdan s’est associé à la société de services Terra Quantum pour relever un défi informatique qui est apparu dans la gestion de ses solutions d’investissement. Le partenariat s’est concentré sur les produits dérivés exotiques, qui masquent de réelles complexités en termes de calcul car ils sont représentés par des fonctions mathématiques sans formules fermées.

« Il n’existe pas d’équation [simple]qui dise que X plus Y égale la valeur du dérivé », résume Antonio de Negri, PDG du groupe Cirdan. « Nous devons donc calculer nos produits dérivés en effectuant des milliers et des milliers de simulations de Monte-Carlo (méthode algorithmique visant à calculer une valeur numérique approchée en utilisant des techniques probabilistes, NDLR) ». Avec l’informatique haute performance (HPC) traditionnelle, ce processus est fastidieux et prend beaucoup de temps. Ce qui n’a pas empêché des institutions financières telles que Cirdan d’avancer, effectuant ces calculs fastidieux seuls à même de les aider à comprendre le risque de ces actifs et à le gérer plus efficacement.

Cirdan a utilisé les meilleures capacités informatiques classiques pour s’attaquer au problème, mais les calculs restaient longs et coûteux. Avec une approche quantique, Terra est parvenu à réduire le temps de calcul de 75 % – de 10 à 2 minutes – en conservant la même précision. Les prochaines itérations devraient permettre de réaliser des économies encore plus importantes, estime Antonio de Negri.

L’impact du quantique sur le machine learning

Huit minutes, cela peut sembler peu. Mais cela peut se traduire par des gains importants. « Compte tenu de la taille du portefeuille ou de l’importance des paris que font les institutions financières, si vous pouvez faire un calcul légèrement meilleur, même de 0,1 %, ou si vous parvenez à l’effectuer plus rapidement qu’auparavant, cela représente déjà un gain important », tranche Benno Broer, qui se souvient de l’époque où il travaillait avec des modèles basés sur Excel pour évaluer le risque des portefeuilles financiers. « Nous lancions nos modèles, appuyions sur « run » et devions attendre le matin en espérant ques le modèles ne s’effondrent pas pendant la nuit », se remémore-t-il. « Il est assez facile de se heurter aux limites de l’informatique classique si l’on dispose d’une grande quantité de données, d’un grand nombre d’actifs différents à échanger ou de nombreux clients différents à qui l’on accorde un prêt », illustre Benno Broer.

Les problèmes d’optimisation tels que ceux auxquels Ally et Cirdan se sont attaqués sont bien adaptés à l’informatique quantique. Car, sur ce terrain, l’informatique classique n’a pas les moyens de fournir des résultats significatifs dans un délai raisonnable. Mais le quantique promet également de rendre le Machine Learning plus efficace, observe Vishal Shete, directeur général pour le Royaume-Uni et responsable des ventes de Terra Quantum AG. Parce que les qubits, les éléments constitutifs du quantique, « peuvent apprendre avec des données beaucoup moins nombreuses et moins harmonisées, ils sont très efficaces en matière d’apprentissage », note-t-il. Cela signifie que le quantique peut relever les défis du Machine Learning avec moins de contraintes que le HPC traditionnel.

Trouver le cas d’usage qui apporte une plus-value

Nilesh Vaidya, vice-président exécutif de la société de conseil Capgemini, abonde : « l’application de techniques de Machine Learning avec l’informatique quantique permet de préparer les modèles mieux et plus rapidement. Aujourd’hui, il faut un certain temps pour créer et déployer des modèles et visualiser les résultats, mais avec le quantique, certaines parties de ce processus peuvent être accélérées drastiquement. »

Outre les critères de faisabilité technique, Vishal Shete conseille aux entreprises de sélectionner les projets pour lesquels une amélioration, même minime, peut apporter une valeur métier ou commerciale certaine. L’intérêt des parties prenantes pour la technologie est également essentiel. « Si tous les autres facteurs sont réunis, mais que le responsable métier avec lequel vous travaillez résiste au changement ou n’y est pas disposé, c’est une pierre d’achoppement », observe-t-il.

« Si vous comprenez les forces et faiblesses du quantique, vous pouvez trouver dans chaque domaine un bon créneau où apporter une valeur ajoutée importante », estime Benno Broer. « Mais si vous pensez que la technologie peut apporter une valeur ajoutée dans tous les domaines, vous serez déçu. C’est comme un marteau qui cherche un clou : cela va demander beaucoup de travail pour trouver ce clou, mais une fois que vous l’avez identifié, vous pouvez commencer ».

Partenariats entre l’industrie et les fournisseurs de quantique

Justement, comment démarrer avec le quantique ? Si quelques institutions financières mettent en place leurs propres équipes dédiées dès le départ, beaucoup choisissent de s’associer à des experts dans ce domaine. Pour Markus Pflitsch, PDG et fondateur de Terra Quantum, « il est même tout simplement impossible pour les banques et les entreprises d’autres secteurs de créer des capacités quantiques en interne, compte tenu de la pénurie de compétences ». En plus de fournir un accès au matériel spécifique à cette technologie, les entreprises telles que Terra Quantum peuvent exécuter des logiciels quantiques sur des simulateurs internes basés sur des composants HPC classiques. C’est d’ailleurs ainsi que Cirdan a résolu son problème de dérivés exotiques. Lorsque les ordinateurs quantiques dépasseront le stade des dispositifs NISQ* actuels, Terra Quantum a prévu d’adapter sa technologie à ces plates-formes.

Vishal Shete (Terra Quantum) souligne que les spécialistes du quantique peuvent également polliniser les solutions développées pour la finance vers d’autres secteurs. Par exemple, « le travail de simulation que nous effectuons sur le prix des options présente de nombreuses similitudes avec le travail de simulation moléculaire effectué dans la chimie », observe-t-il. Autrement dit, une société spécialisée dans le quantique pourrait faire germer des idées empruntées à un secteur dans d’autres secteurs.

Prédire le comportement des clients, modéliser les pertes de crédit

L’un des défis du Machine Learning sur lequel Terra Quantum travaille actuellement consiste à comprendre les clients à l’aide de modèles de prédiction de séries temporelles : « il s’agit de prédire le comportement des clients, de comprendre comment ils vont réagir, de trouver le meilleur regroupement de clients, d’identifier les corrélations les plus pertinentes et leurs associations, et donc, in fine, de déterminer les produits vers lesquels les clients devraient être orientés », résume Vishal Shete.

Dans la finance, les prédictions de séries temporelles aident à comprendre le comportement des marchés et à évaluer la corrélation entre différents types d’actifs. Dans le domaine de la gestion des risques, le quantique peut aussi être déployé « pour des simulations de Monte-Carlo ou pour comprendre les problèmes de lutte contre le blanchiment d’argent ou de conformité, qui peuvent se poser au sein de votre banque », reprend le responsable des ventes de Terra Quantum.

Pour sa part, Ally prévoit d’évaluer d’autres projets, notamment la modélisation des pertes de crédit, afin de prédire le pourcentage de prêts accordés aux clients susceptibles de se solder par des pertes. Les proof-of-concept qu’Ally a menés jusqu’à présent sur le quantique constituent son galop d’essai, une préparation pour le moment où le quantique sera prêt pour une mise en production massive. Pour son DSI, directeur des data et du digital, Sathish Muthukrishnan, cette phase de préparation est essentielle : « c’est comme si vous vous entraîniez constamment et que vous faisiez vos sprints afin d’être prêt lorsque la vraie course aura lieu. Il ne faut pas rester assis à attendre que les choses se passent – tout est question de cohérence, de préparation et de capacité à se montrer à la hauteur de la situation au moment opportun. »

* : le NISQ (acronyme de Noisy Intermediate Scale Quantum, ou quantique d’échelle intermédiaire bruité) désigne des machines de 50 à 100 qubits sans correction d’erreur fiable capables toutefois de réaliser certaines tâches au-delà des capacités des ordinateurs classiques.